Algoritmos públicos: ¿Qué hace el Estado con nuestros datos?

/cloudfront-us-east-1.images.arcpublishing.com/copesa/QMW4JJHUABDEZGDWCXI3PCOGMA.jpg)

En tiempos donde la automatización de los procesos mejora su eficiencia, las instituciones públicas confían más sus acciones a sistemas algorítmicos ¿Pero funcionan de forma adecuada?

Listas de espera, sistema de admisión escolar, reconocimiento de patentes y beneficios carcelarios tienen un punto en común: todos funcionan con sistemas de algoritmos automatizados o semiautomatizados. La incontable cantidad de datos que existe sobre nosotros es usada día a día por organismos públicos para optimizar y mejorar las decisiones que toman sobre nosotros. Pero ¿qué tan conscientes estamos de que existen estos sistemas y de que funcionen de forma adecuada?

La Universidad Adolfo Ibáñez creó un sistema donde es posible reconocer y vigilar estos sistemas de Algoritmos Públicos: si se utilizan datos públicos, si se cuida la información privada y si efectivamente es posible entender el funcionamiento del manejo de información de todos nosotros que el Estado opera. Al mismo tiempo, esto ayuda a incentivar a las instituciones públicas a usar datos como herramienta de innovación pública, y a su vez, caracterizar el uso de sistemas computacionales y algoritmos por parte de las instituciones estatales.

“Nosotros nacimos con la idea de apoyar al sector público en el proceso de transformación, usando ciencia de datos y análisis de datos”, afirma María Paz Hermosilla, directora de GobLab UAI, laboratorio de innovación pública de la Universidad Adolfo Ibáñez y responsable del proyecto de Algoritmos Públicos. La iniciativa, que partió en 2017, busca además impulsar el uso ético de los datos, tanto para los funcionarios que emplean y ejecutan este tipo de sistemas automatizados, como para la ciudadanía que es sujeto de decisiones tomadas con algoritmos.

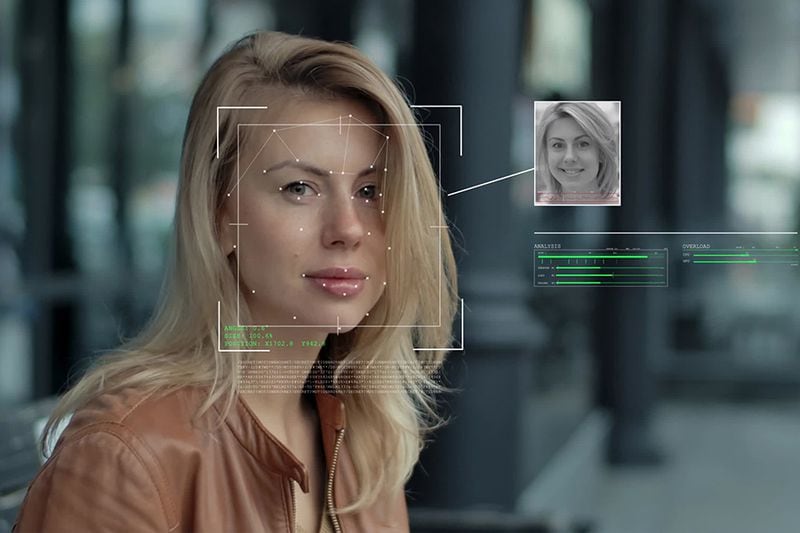

En el repositorio se encuentran registrados hasta ahora 50 iniciativas que el Estado utiliza para realizar distintas tareas de manera automatizada. Desde bots para denunciar violencia intrafamiliar; sistemas de lista de espera en el sector público de Salud, hasta telemedicina con Inteligencia Artificial para detectar Covid-19. También hay otros programas automatizados que implementa el Estado, como sistemas de reconocimiento facial en el Metro de Valparaíso; de análisis de licencias médicas y algoritmos de evaluación de beneficios carcelarios, entre muchas otras. Según cuenta Hermosilla, en las próximas semanas agregarán 25 nuevos sistemas de algoritmos públicos al repositorio.

“En transporte también hay muchos sistemas automatizados que pueden terminar en un parte, por ejemplo. Los partes empadronados están alimentados de algoritmos que genera un universo de posibles infracciones, y luego un inspector decide si efectivamente hay una infracción o no”, agrega Hermosilla.

Para la ciudadanía a veces no se sabe cómo funciona este tipo de sistemas. Hay algunos sistemas automatizados que son más visibles que otros. “En la Medicina hay sistemas importantes que se usan y muchas veces no son conocidos. Es importante entenderlos para que después haya una rendición de cuentas, para vigilar que estos sistemas estén usados respetando la norma, que se protejan los datos personales y que sean proporcionales al problema”, manifiesta.

Buen uso de los datos

Si bien, hay múltiples instancias donde se utilizan datos de los ciudadanos para optimizar las tareas del Estados, ¿cómo saber cuál es la información que se está utilizando y si se emplea de forma correcta? El GobLab, junto al Consejo para la Transparencia (CPLT) realizó un catastro de los Sistemas de Decisión Automatizada (SDA) que utiliza el sector público. De los casos estudiados, el 80% no tenía información pública y el 78% usaba datos personales. “Además, miramos en profundidad a 12 sistemas e intentamos ver si con la información pública que había a disposición éramos capaces de entender qué hacía ese sistema”, agrega la directora del GobLab.

Con eso, el CPLT decidió comenzar el proceso de crear una Norma vinculante de Transparencia Algorítmica para el Estado. Dicha norma mandataría al sector público a publicar todos sus sistemas automatizados, explicando qué tipo de información utilizan y cómo operan con dichos datos para tomar sus decisiones. Ahora, para entender si utilizan bien los datos en sus sistemas automatizados, es necesario considerar las siguientes dimensiones.

La primera es la proporcionalidad “¿Es proporcional el uso de la tecnología para resolver un problema? ¿Necesitamos un Bulldozer para matar una hormiga? La idea es que los problemas atendidos con datos puedan resolverse de la manera más sencilla y a menor costo posible”, detalla Hermosilla. El segundo punto a considerar apunta a la licencia social. La legitimidad o aceptabilidad de un sistema por parte de sus usuarios, y por parte de la ciudadanía que le otorgan a algunos sistemas automatizados. “Hay discusiones que van mucho más allá de los algoritmos, pero que es importante tener en consideración. Por ejemplo, el reconocimiento facial en muchas partes del mundo se está volviendo poco aceptable y sólo para usos de seguridad”, enfatiza la académica.

Por otro lado, también es importante tener en cuenta la correcta protección de datos y la transparencia en cómo estos se utilizan. Es necesario, además, considerar que un algoritmo funciona de manera equitativa y que no realice discriminaciones por “criterios incorrectos. Por ejemplo, un sistema de detección de Covid no debería detectarlo con mayor frecuencia en hombres que en mujeres, o tener un mayor porcentaje de error en unas personas más que en otras”, añade.

Además, según explica Hermosilla, es importante que un algoritmo público esté abierto a la rendición de cuentas, que sea posible monitorear, rectificar en caso de errores y mantener un proceso constante de evaluación y control.

¿Cómo están siendo empleados los algoritmos públicos actualmente? Según reconoce la directora de GobLab, es difícil tener una evaluación de esos parámetros porque es muy costoso realizar ese tipo de fiscalización en este momento. “Hicimos siete solicitudes donde no nos fue muy bien, y no encontramos toda la información necesaria para realizar este tipo de evaluación ética del sistema”, expresa.

Si bien, existen iniciativas donde se busca realizar estudios de discriminación algorítmica, estos requieren mucha información, evaluaciones y acceso que aún cuesta tener a disposición. “Esperemos que la nueva Ley de Protección de Datos venga con una cláusula de que, cuando uno sea sujeto de una decisión automatizada, se deba explicar cómo funciona. Es una puerta de entrada para entender cómo los algoritmos simples o de Inteligencia Artificial están ayudando a tomar importantes decisiones.”, cierra Hermosilla.

Comenta

Por favor, inicia sesión en La Tercera para acceder a los comentarios.