Por Marcelo Contreras

Por Marcelo ContrerasMúsica generada por Inteligencia Artificial: Cómo es (y será) el pop sin humanos

Michael Jackson en un éxito de Maluma, Drake cantando con The Weeknd, y Liam Gallagher replicado por algoritmos. La Inteligencia Artificial ya puede imitar voces famosas, pero la originalidad sigue en deuda. ¿Está en jaque el factor humano en el futuro de la música pop? "Me imagino un futuro cercano donde en la música va a haber una etiqueta que va a decir ‘human made’ (...) y probablemente va a ser más cara, como los productos artesanales”, dice uno de los expertos consultados.

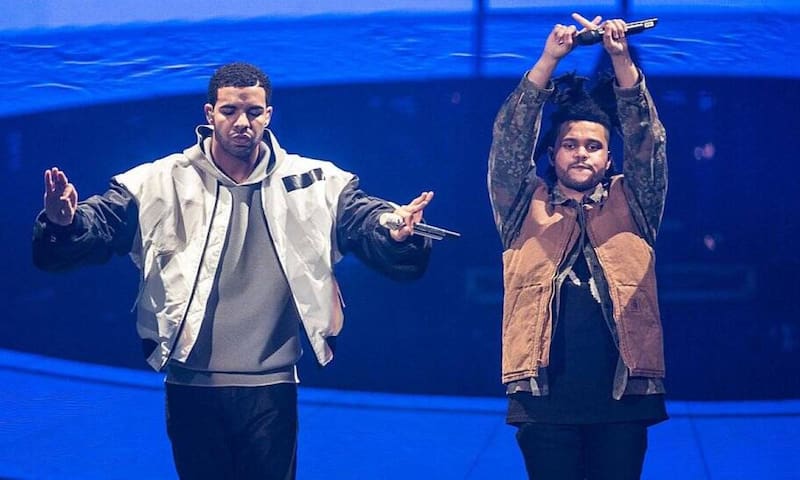

15 millones de reproducciones en TikTok. 600 mil reproducciones en Spotify y 9.400 dólares en ganancias en distintas plataformas. Heart on my sleeve, canción publicada por el usuario ghostwriter977 de TikTok el pasado 4 de abril, se convirtió en un éxito por reunir a Drake y The Weeknd mediante Inteligencia Artificial, sin que ninguno haya participado en su registro.

Luego vino el turno de Aisis, un supuesto disco perdido de Oasis. En rigor, unas viejas canciones de los desconocidos Breezer, una banda británica que mediante Inteligencia Artificial recreó a Liam Gallagher. El cantante no escuchó el álbum completo, pero destacó que una de las piezas “es mejor que todas las demás que hay por ahí”.

También apareció una versión de Cuatro Babys de Maluma con la voz de Michael Jackson. Los resultados, discutibles.

En medio de este fervor musical por IA, la reputada artista synth pop Grimes, ex de Elon Musk, ofreció compartir ganancias a quienes utilicen su material bajo esta modalidad. “Dividiré el 50% de las regalías en cualquier canción exitosa generada por IA que use mi voz”, anunció en Twitter.

Paradójicamente, Heart of my sleeve fue eliminada de plataformas musicales no por contener simulaciones de Drake y The Weeknd, sino por incluir sin autorización un sample. En términos legales, el uso de pistas vocales representa una zona gris, porque la voz no considera derechos de autor. Por esa razón Universal Music Group, uno de los gigantes de la industria discográfica, pretende bloquear sus catálogos para entrenar algoritmos y así producir canciones por IA.

La Oficina de Derechos de Autor de Estados Unidos sostiene que no concederá beneficios a “obras que carezcan de autoría humana”. La entidad no reconocerá material producido por máquinas y procesos mecánicos “que funcionen de forma aleatoria o automática sin ninguna aportación creativa o intervención de un autor humano”.

No solo reaccionó el sello Universal, sino que se activó Human artistry campaign, una cruzada que pretende encauzar la IA “de forma responsable”.

“Los avances de la inteligencia artificial son apasionantes y podrían hacer avanzar el mundo más de lo que jamás creímos posible”, proclaman, “pero la IA nunca podrá sustituir a la expresión y el arte humanos”.

“La música no consiste solo en crear melodías”

Una manifestación de Inteligencia Artificial como ChatGPT también descarta el reemplazo. “La música no consiste solo en crear melodías”, responde el chatbot, “sino también en transmitir emociones y expresar sentimientos que solo los seres humanos pueden experimentar”. “Los músicos aportan una interpretación única y un toque personal a su música que la IA no puede reproducir”.

Para ChatGPT, la IA funciona como una herramienta para “crear nuevos sonidos, componer música o mejorar sus habilidades”, pero es incapaz de reemplazar la esfera creativa y emotiva de la composición “esenciales para la experiencia humana”.

Hasta ahora, estos casos de música trabajada en IA replican el estilo de grandes estrellas, sin crear estrictas novedades. Pero la originalidad es posible, según ChatGPT. “Los sistemas de IA pueden entrenarse con grandes conjuntos de datos de música existente para aprender los patrones y estructuras (...) y luego generar nuevas piezas musicales totalmente originales”.

Un camino posible consiste en utilizar redes generativas adversarias (GAN) donde participan dos redes neuronales, una generadora y otra discriminadora. “El generador crea música nueva”, explica el chatbot, “y el discriminador la evalúa para determinar si es original o similar a la música existente”.

“Mediante un proceso iterativo de entrenamiento”, continúa, “el generador aprende a crear música que el discriminador no puede distinguir de la música original”.

La respuesta de ChatGPT admite que aún cuando la originalidad de la música por IA es debatible, “sí puede igualar realmente la creatividad y la profundidad emocional de la música creada por músicos humanos”.

¿Sin trabajo?

La relación entre electrónica y música se remonta al ordenador australiano CSIRAC, la cuarta computadora del mundo y pionera en reproducir música entre 1950 y 1951. En 1957 se desarrolló MUSIC-1 en laboratorios Bell, el primer programa para componer música en un computador. Tres años más tarde el investigador ruso Rudolf Zaripov publicó el primer texto sobre composición musical, utilizando algoritmos mediante el ordenador Ural-1.

La primera composición de un computador fue presentada en 1965 por el ingeniero informático, futurólogo e inventor estadounidense Ray Kurzweil. La máquina podía analizar patrones de distintas piezas y luego crear una original. Décadas después, en 1997, el programa de IA Experiments in Musical Intelligence (EMI) compuso material siguiendo el estilo de Bach.

Así como la Revolución Industrial dejó progresivamente obsoletos una serie de oficios junto con crear otros, ¿puede esta variable de la Inteligencia Artificial poner en peligro el futuro de la escena musical?

El productor y músico Pablo Stipicic, ganador de tres premios Pulsar y con trabajos para series de Netflix, HBO y Amazon Prime Video, recurre al clásico cinematográfico The Matrix para explicar este momento.

“Es como cuando Morpheus le decía a Neo ‘yo sé que los agentes son rápidos, pero nunca van a ser tan rápidos como tú, porque están limitados por las reglas’. En este caso, el ser humano está en el lugar de Neo y la IA en el lugar de los agentes”, explica.

“Pero, eventualmente, la misma IA va a poder desarrollar esa capacidad”, advierte. “Estas herramientas se van a sofisticar, se van a optimizar. Todo esto va mucho más rápido de lo que se pudo imaginar, y me imagino un futuro cercano donde en la música va a haber una etiqueta que va a decir ‘human made’ (...) y probablemente va a ser más cara, como los productos artesanales”.

Por ahora, subraya Stipicic, “todavía está limitada a la copia y no tiene la capacidad de generar algo completamente nuevo y dar vuelta la mesa”.

Para Carlos Cabezas, líder de Electrodomésticos y uno de los pioneros de la combinación entre máquinas, sintetizadores y rock en Chile, este escenario resulta complejo pero no particularmente inquietante.

“Me hace recordar cuando estaba partiendo la música electrónica y apareció el sampler”, evoca el músico. “El ser humano estaba buscando, con toda esta musculatura científica que había desarrollado en los años 60, imitar el sonido de los instrumentos normales, un violín, un piano. Esa búsqueda terminó abriendo un espacio nuevo increíble”.

Sin embargo, Cabezas advierte que “la música nos comunica en otro nivel”. “Nos conecta de manera visceral, intuitiva, ancestral. Los recitales son ceremonias tribales donde todos sentimos algo en común que, eventualmente, se puede racionalizar, pero que es muy distinto a un espacio racional”.

Con siete álbumes y nominada a los Pulsar, la artista electrónica Alisú considera que el factor humano es determinante e irreemplazable creativamente, aún cuando sea a través de máquinas. “Me parece interesante, pero hacer música desde el ser humano tiene alma, y sobre esa experiencia, esa sensibilidad, no se puede competir”.

“En términos musicales”, continúa, “va a ayudar a gente sin conocimientos. Pero, en mi caso, alguien que me busque para la música de un cortometraje o realidad virtual, es difícil que la IA me reemplace por el bagaje. Esa es la diferencia al trabajar con un músico y un productor, versus la IA”.

Carlos Cabezas coincide. Aunque los procesos se automatizan progresivamente, la esencia de la música “a nivel de sentimientos, de pulsación orgánica humana, es bien difícil que se pueda generar de manera artificial”.

“La expresión artística se alimenta de elementos complejos para descomponer en términos racionales”, continúa. “Cuesta mucho entender cómo se podría simular una sensación de dolor, de alegría, de pena, elementos que comunica la música”.

“Yo he escuchado material que se hace por Inteligencia artificial y no te para ningún pelo”, asegura. “Es totalmente frío, sin vida”.

“Puede que el arte quede como uno de los pocos bastiones humanos donde uno sienta la humanidad”, complementa Pablo Stipicic.

“Lo veo como una herramienta y más exigente para quienes hacen música electrónica”, apunta Alisú. “Pero no creo que me quite el trabajo”.

COMENTARIOS

Para comentar este artículo debes ser suscriptor.

Lo Último

Lo más leído

1.

2.

3.

4.