Por Francisco Corvalán

Por Francisco CorvalánChatGPT dio la PAES y estos fueron los resultados

Para probar la capacidad de respuesta que ofrece esta herramienta creada por OpenAI, se puso a prueba con el examen estandarizado para acceder a la Educación Superior. Todavía esta inteligencia artificial "alucina" con ciertas preguntas y comete errores.

¿Debería la inteligencia artificial obtener un puntaje perfecto en la PAES? La herramienta que revolucionó a todos durante el último año fue puesta a prueba con la Prueba de Admisión a la Educación Superior para saber qué tan capaz es de entender y resolver un problema de comprensión lectora, historia, matemáticas o de ciencias. Los resultados mostraron algo sorprendente.

Las nuevas actualizaciones de ChatGPT, que ahora puede “ver” y responder preguntas con gráficos y otras formas que antes no podía, también influyó en que éste recibiera cuestionamientos de que se habría vuelto menos inteligente. ¿Cómo esto puede afectar su capacidad de responder la PAES?

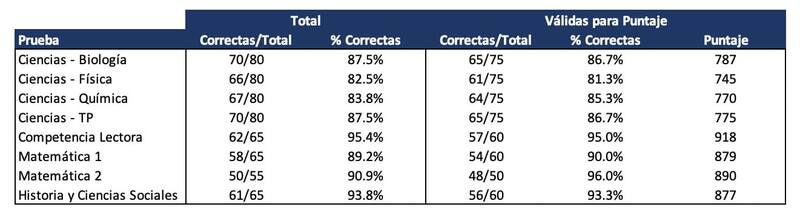

Fue lo que intentó verificar el equipo de EvoAcademy, una academia digital dedicada a desarrollar las últimas tendencias en tecnología, inteligencia artificial y marketing digital. La empresa puso a prueba esta herramienta ante la PAES. ChatGPT obtuvo entre un 81,3% hasta un 96% de las respuestas correctas. El puntaje más bajo que sacó fue 745, en la prueba de Física, y el más alto fue 918, en la prueba de Competencia Lectora.

Usando la herramienta WebPlotDigitizer, además extrajeron las densidades estimadas de las distribuciones de puntajes PAES reportados en gráficos por DEMRE. Con esta información fue posible estimar que ChatGPT hubiese estado dentro del 4% superior de quienes rindieron la prueba de Comprensión Lectora, que fue su mejor prueba.

“Estábamos acostumbrados a que la tecnología fuera muy de instrucción y respuesta. Y los modelos de lenguaje enorme, como ChatGPT, no funcionan así”, comenta Sebastián Cisterna, CEO de Evoacademy. Lo que hacen en realidad esta tecnologías es predecir cuál es la siguiente mejor palabra en base a la información que tienen. “Por ejemplo, si digo ‘camarón que se duerme, se lo lleva la...’ la IA me diría en base a ese contexto que lo que viene es ‘la corriente’. Esa es la función que hacen principalmente. Y por lo mismo, cada vez que tú le das una instrucción, va a tratar de decir cuál es la palabra o concepto más probable que viene después”, agrega.

ChatGPT rindió la PAES y no tuvo puntaje perfecto: ¿Por qué se equivocó esta IA?

Entonces eso hace que ChatGPT sea muy coherente al hablar, pero que a veces estas respuestas no siempre sean ciertas. A este fenómeno se le conoce como “alucinación”.

Las alucinaciones son parte de la inteligencias artificiales generativas, como un chat GPT o similares, y son estas en particular las que tienen ese problema. “Se puede reducir eso al modificar parte del código y así poder bajar el número de esas alucinaciones, pero nunca se pueden disminuir a cero”, explica Cisterna. Según cuenta, esta característica de alucinar es algo inherente al programa.

Ahora que la nueva actualización de esta tecnología le permite “ver” imágenes e interpretarlas, ChatGPT pudo responder mejor preguntas relacionadas a problemas matemáticos asociados a gráficos y diagramas. Aunque todavía le cuesta interpretar ilustraciones de la prueba de Biología e imágenes más complejas.

“Por ejemplo, en matemáticas hay varios problemas de geometría, y en ese caso los abordó súper bien, obviamente con las alusiones respectivas. Lo que nos sorprendió es que en ciencias no las interpretó tan bien. Pareciera que en el fondo ciencias es una rama un poquito más compleja de interpretar las figuras que están ahí”, complementa.

De todas formas, el experto en inteligencia artificial cuenta que esto no es algo generalizable, porque en matemáticas les fue muy bien. Esto se puede corregir, al generar una instancia más personalizada hecha en GPT que estuviera más acostumbrada a estos problemas y a esto se le llama “fine-tuning”. “Creo que uno podría eventualmente hacer un PAES-GPT, por decirlo de alguna manera, y poder llevar su conocimiento específico de la materia un poco más allá”, describe.

Si uno lo ajustara e hiciera este proceso de fine-tuning, para poder específicamente enseñarle un poco más de la PAES, probablemente llegaría a un mejor resultado. Asimismo, Cisterna detalla que debido a su porcentaje de alucinaciones, esta herramienta podría ser más útil para un estudiante que esté dentro o bajo del promedio del puntaje obtenido.

“Nosotros esperábamos que le fuera un poquito mejor de lo que le fue, porque en base a los experimentos anteriores le había ido mejor. En las pruebas que hicimos en abril, con otras pruebas que había publicado el Demre le fue mejor”, remarca. A esto se debe considerar que en las pruebas anteriores no se había considerado la interpretación de imágenes, por lo que solo se probó en exámenes de comprensión lectora y aplicación de conocimientos escritos.

Finalmente, Cisterna comenta que la prueba de ChatGPT se hizo tanto en su versión gratuita, como también en la pagada. De aquí se desprendió que la versión con suscripción tuvo un mayor rendimiento que la de acceso libre. El desempeño mejoró entre un 15% y un 20% al rendir la PAES con la versión pagada. Ante esto, el CEO de Evoacademy explica que esto ocurre porque la versión gratuita aún funciona con la versión GPT3.4, mientras que la pagada ya cuenta con las actualizaciones de GPT4.0.

COMENTARIOS

Para comentar este artículo debes ser suscriptor.

Lo Último

Lo más leído

1.

2.

4.