Una joven vende sus fotos íntimas, pero en realidad no existe: son creadas por Inteligencia Artificial

Un grupo de expertos advirtió que un perfil de redes sociales que se identifica como “Claudia” y que vende fotos íntimas es en realidad un avatar creado con inteligencia artificial. Este es solo uno de miles de casos que figuran en la internet.

Durante los últimos años, la industria de la tecnología ha destacado por sus acelerados avances. A través de la inteligencia artificial (IA), hoy es posible generar textos a partir de simples tópicos con plataformas como ChatGPT, mientras que otras como DALL-E permiten la creación de imágenes mediante una sencilla descripción.

Si bien, tanto esas herramientas como otras como Stable Diffusion y Midjourney pueden ser útiles para objetivos como buscar inspiración u ordenar ideas, también hay personas que las están usando para propósitos como fomentar la desinformación o, incluso, vender pornografía en la que avatares simulan ser humanos.

Tales puntos son solo algunos de los que han preocupado a numerosos especialistas de diversas áreas, quienes han advertido que estas aplicaciones pueden cometer errores en cuanto a datos y que podrían ser peligrosas para la humanidad si no se ajustan en detalle o se imponen marcos regulatorios.

En medio de un escenario en donde estos sistemas son capaces de crear imágenes extremadamente realistas, se ha alertado sobre cuentas de redes sociales que ofrecen fotos de desnudos a cambio de dinero. Pero con un factor significativo que no es contado a los otros usuarios: son creadas con IA.

Así lo aseguraron distintos expertos al Washington Post, quienes identificaron perfiles de este tipo en sitios como Instagram, Twitter, OnlyFans y Reddit.

El avatar creado con Inteligencia Artificial que se hace pasar por una mujer

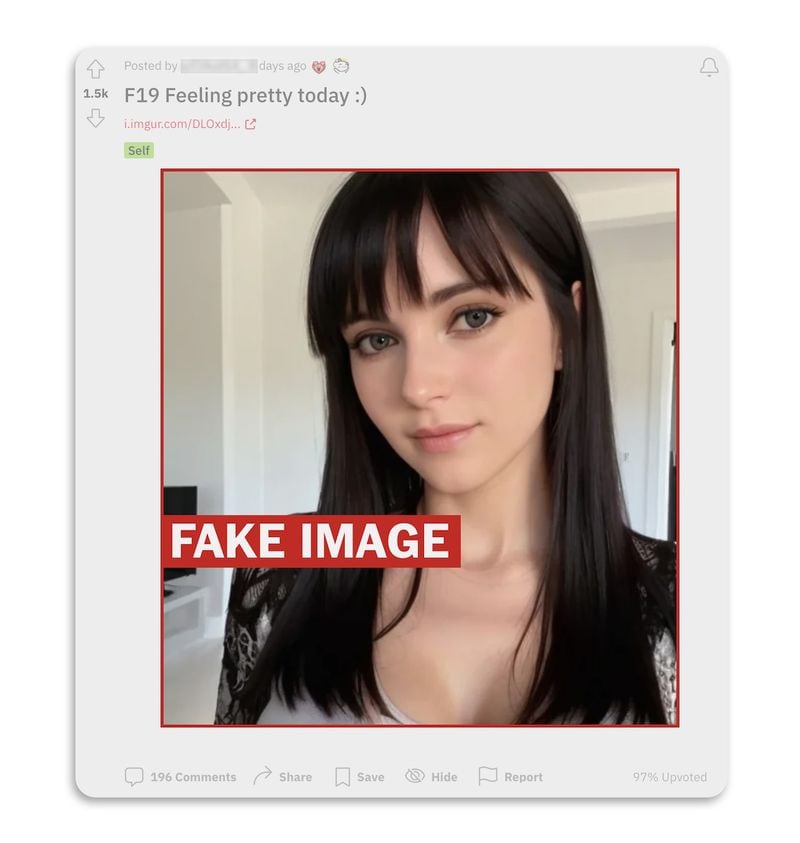

Uno de los casos más controversiales es el de “Claudia”, una cuenta de este último sitio que comparte imágenes y mensajes en tono explícito, a través de la figura de una mujer con piel blanca, pelo negro y ojos verdes que dice tener 19 años y vender contenidos.

Hace dos semanas publicó una foto de su rostro, la cual pese a que tuvo comentarios de cibernautas que sugirieron que se veía “demasiado perfecta” para ser real, otros se limitaron a destacar sus atributos físicos, dando a entender que confiaban en su legitimidad.

Tras analizar el perfil, los expertos dijeron al Post que lo más probable es que se trate de una imagen creada con IA, debido a que notaron aspectos sospechosos en las texturas del fondo y a que un lunar de su cuello desaparece entre distintas tomas.

A ello se le suma, según uno de ellos, que el ancho de la foto de 512 pixeles tiene el tamaño por defecto de Stable Diffusion, por lo que presumió que se hizo con esa aplicación.

De la misma manera, otro sometió su primera publicación escrita al análisis de ZeroGPT, una herramienta capaz detectar si las oraciones fueron armadas por una IA.

Ahí, el sistema manifestó estar 97% seguro de que fue escrito por una app como ChatGPT.

Y a pesar de que desde el Post le escribieron por interno a “Claudia” para conocer más detalles, no respondió a ninguno de los mensajes en Reddit.

La trastienda de las cuentas creadas con IA que venden fotos íntimas

Los expertos estiman que hay miles de perfiles de este tipo que se hacen pasar por personas reales, los cuales venden contenidos y podrían llegar a cometer engaños mayores, como el robo de información.

Según ellos, la gran mayoría simulan ser mujeres o niñas y tienen fines relacionados con la pornografía.

Incluso, algunos de los usuarios optan por recurrir a los programas por su propia cuenta para crear imágenes. Por ejemplo, un administrador de hospital confesó bajo anonimato que recurre a estos métodos para generar fotos de mujeres adultas en pañales, una escena que —en su caso— cabría en la categoría del fetichismo.

Bajo esta línea, destacó que son tan realistas que “no creo que a la persona media que ve estas cosas le importe (...) al fin y al cabo, si no son reales, ¿a quién le interesa?”.

Frente a esta situación, Sam Gregory, quien dirige la organización enfocada en tecnología y Derechos Humanos, Witness, explicó al Post que estos nuevos mecanismos de IA aumentan los riesgos de que se suplanten los rostros de mujeres, para así ponerlos en situaciones ficticias.

“El paso a los modelos de difusión (los que crean imágenes a partir de palabras) ha facilitado mucho la creación de volumen, varianza y personalización”, advirtió, para luego recalcar que a pesar de que los montajes en sí son falsos, estos igual pueden dañar la integridad de las personas a través de la humillación.

Comenta

Por favor, inicia sesión en La Tercera para acceder a los comentarios.